早期词嵌入模型

CBOW和Skip-gram

CBOW在训练过程中把每个词都预测一遍。

BERT在训练过程中作者随机mask 15%的token。

BERT模型

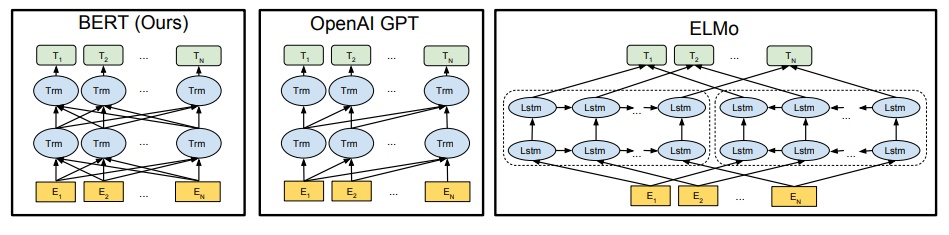

BERT的全称是Bidirectional Encoder Representation from Transformers,即双向Transformer的Encoder,因为decoder是不能获要预测的信息的。模型的主要创新点都在pre-train方法上,即用了Masked LM和Next Sentence Prediction两种方法分别捕捉词语和句子级别的representation

Embedding

这里的Embedding由三种Embedding求和而成:

BERT 的训练

Approach 1: Masked LM

Approach 2: Next Sentence Prediction

同时用方法1和方法2训练效果比较好

BERT 的使用

- Single sentence classify ,对【CLS】的输出向量接一个线性分类器

- Slot filling,对每一个word的输出向量接一个线性分类器

- Natural Language Inference ,对【CLS】的输出向量接一个线性分类器

- Extraction-based Question Answering ,对document的输出向量做dot product计算开始坐标和结束坐标